No se pierda a los líderes de OpenAI, Chevron, Nvidia, Kaiser Permanente y Capital One en VentureBeat Transform 2024. Obtenga información esencial sobre GenAI y haga crecer su red en este evento exclusivo de tres días. Más información

Actualmente, una de las formas de IA adversaria de más rápido crecimiento, se espera que las pérdidas por deepfake aumenten de 12.300 millones de dólares en 2023 a 40 mil millones de dólares para 2027con una asombrosa tasa de crecimiento anual compuesto del 32%. Deloitte Los deepfakes proliferarán en los próximos años, siendo los servicios bancarios y financieros los principales objetivos.

Los deepfakes son típicos de la vanguardia de los ataques adversarios de IA y alcanzan un 3.000% de aumento apenas el año pasado. Se predice que los incidentes deep fake aumentarán entre un 50% y un 60% en 2024, con 140.000 a 150.000 casos en todo el mundo previsto este año.

La última generación de aplicaciones, herramientas y plataformas de IA generativa proporciona a los atacantes lo que necesitan para crear vídeos profundamente falsos, voces falsificadas y documentos fraudulentos de forma rápida y a muy bajo coste. Gotas de agua‘ Informe de seguridad e inteligencia de voz 2024 estima que el fraude falso dirigido a los centros de contacto cuesta alrededor de 5 mil millones de dólares al año. Su informe destaca la gravedad de la amenaza que representa la tecnología ultrafalsa para los servicios bancarios y financieros.

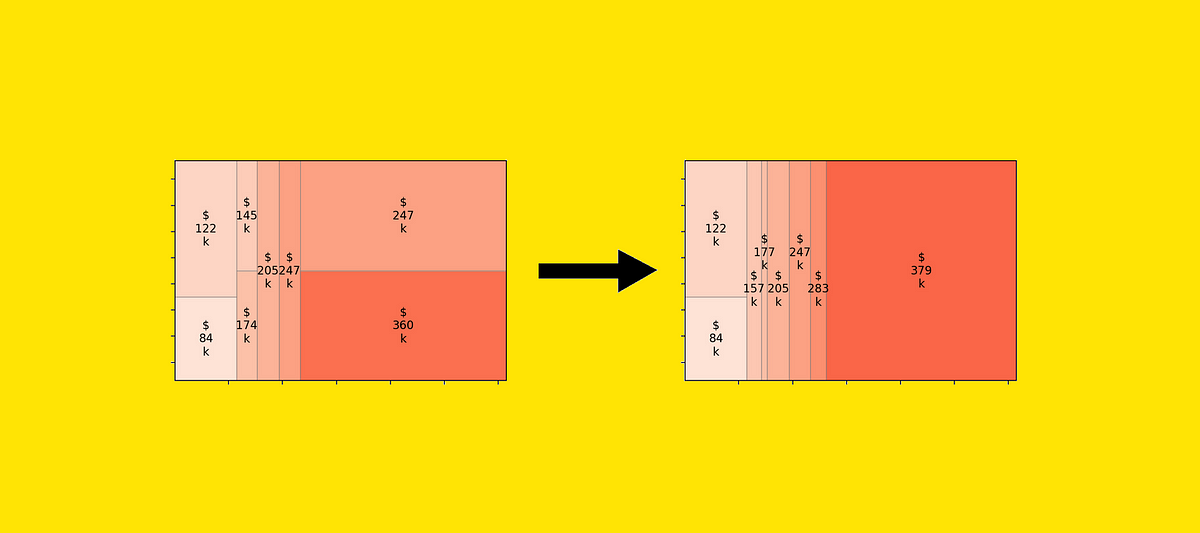

Bloomberg El año pasado, un informe decía que ya existía «una verdadera industria artesanal en la web oscura que vende software fraudulento por entre 20 y miles de dólares». Una infografía reciente basada en Informe de fraude de identidad de Sumsub 2023 proporciona una visión holística del rápido crecimiento del fraude impulsado por la IA.

Cuenta regresiva para VB Transform 2024

Únase a los líderes empresariales en San Francisco del 9 al 11 de julio para nuestro evento emblemático de IA. Conéctese con sus pares, explore las oportunidades y desafíos de la IA generativa y aprenda cómo integrar aplicaciones de IA en su industria. Regístrate ahora

Fuente: Statista, ¿Qué tan peligrosos son los deepfakes y otros fraudes basados en inteligencia artificial? 13 de marzo de 2024

Las empresas no están preparadas para los deepfakes y la IA adversaria

La IA adversaria crea nuevos vectores de ataque que nadie ve venir y crea un panorama de amenazas más complejo y matizado que prioriza los ataques basados en la identidad.

Como era de esperar, una de cada tres empresas no tiene una estrategia para hacer frente a los riesgos de un ataque de IA del adversario que probablemente comenzaría con falsificaciones profundas de sus altos ejecutivos. Ivanti’Las últimas investigaciones revelan que el 30% de las empresas no tienen ningún plan para identificar y defenderse de los ataques de IA de los adversarios.

El Ivanti Informe sobre el estado de la ciberseguridad 2024 Según un estudio de Ivanti, el 74% de las empresas encuestadas ya están viendo signos de amenazas impulsadas por la IA. La gran mayoría, el 89%, cree que las amenazas impulsadas por la IA apenas están comenzando. Entre la mayoría de los CISO, CIO y líderes de TI encuestados por Ivanti, al 60 % le preocupa que su organización no esté preparada para defenderse contra amenazas y ataques impulsados por IA. El uso de un deepfake como parte de una estrategia orquestada que incluye phishing, vulnerabilidades de software, ransomware y vulnerabilidades de API se está volviendo cada vez más común. Esto se alinea con las amenazas que los profesionales de la seguridad esperan que se vuelvan más peligrosas debido a la generación de IA.

Fuente: Informe sobre el estado de la ciberseguridad de Ivanti 2024

Los atacantes centran sus esfuerzos de falsificación profunda en los directores ejecutivos

VentureBeat escucha regularmente a los directores ejecutivos de empresas de ciberseguridad de software que prefieren permanecer en el anonimato sobre cómo los deepfakes han pasado de ser falsificaciones fácilmente identificables a videos recientes que parecen legítimos. Los deepfakes de voz y vídeo parecen ser una estrategia de ataque favorita entre los ejecutivos de la industria, con el objetivo de defraudar a sus empresas por millones de dólares. La amenaza se ve agravada por la agresividad con la que los estados nacionales y las organizaciones cibercriminales a gran escala están aumentando sus esfuerzos para desarrollar, reclutar y desarrollar su experiencia con profesionales de la ciberseguridad. Red Adversaria Generativa (GAN) tecnologías. Entre los miles de intentos de falsificación profunda de directores ejecutivos que han tenido lugar sólo este año, el que tiene como objetivo CEO de la agencia de publicidad más grande del mundo. muestra cuán sofisticados se están volviendo los atacantes.

En una reciente Actualización sobre novedades tecnológicas. con el Wall Street Journal, Huelga multitudinaria CEO George Kurtz Kurtz explicó cómo las mejoras en la IA ayudan a los profesionales de la ciberseguridad a defender los sistemas y comentó cómo la usan los atacantes. Kurtz habló con el periodista del WSJ Dustin Volz sobre IA, las elecciones estadounidenses de 2024 y las amenazas que plantean China y Rusia.

“La tecnología deepfake es muy eficaz hoy en día. Creo que esa es una de las áreas que realmente nos preocupa. En 2016, solíamos seguir esto y veíamos personas conversando con robots, y esto era 2016. Literalmente están discutiendo o promoviendo su causa, y están teniendo una conversación interactiva, y es como si no hubiera nadie. Detrás de eso. Así que creo que es bastante fácil para la gente quedar atrapada en lo que es real, o en una narrativa que queremos apoyar, pero mucho de eso puede ser impulsado y ha sido impulsado por otros estados-naciones”, dijo Kurtz.

El equipo de Inteligencia de CrowdStrike ha invertido mucho tiempo para comprender los matices de lo que constituye un deepfake convincente y hacia dónde se dirige la tecnología para lograr el máximo impacto en los espectadores.

Kurtz continuó: “En el pasado descubrimos que dedicamos mucho tiempo a investigar este tema con nuestro equipo de inteligencia CrowdStrike. Es un poco como un guijarro en un estanque. Tomas un tema o escuchas un tema, cualquier cosa relacionada con el entorno geopolítico, y arrojas la piedra al estanque, y luego todas estas olas se propagan. Y es esta amplificación la que se produce. »

CrowdStrike es conocido por su profunda experiencia en IA y aprendizaje automático (ML) y su modelo único de agente único, que ha demostrado ser eficaz para impulsar su estrategia de plataforma. Con tanta experiencia dentro de la empresa, es comprensible que sus equipos estén experimentando con tecnologías ultrafalsas.

“¿Qué pasaría si ahora, en 2024, con la capacidad de crear deepfakes, y algunos de nuestros muchachos internamente hicieran algunos videos de parodia divertidos conmigo y solo para mostrarme lo aterrador que es, no pudiéramos decir que no fui yo el que apareció en el video? video. Así que creo que esa es una de las áreas que realmente me preocupan”, dijo Kurtz. “Siempre hay preocupaciones sobre la infraestructura y ese tipo de cosas. En estas áreas, mucho todavía gira en torno a la votación en papel y cosas similares. En algunos casos no lo es, pero cómo se crea la narrativa falsa para lograr que la gente haga lo que un estado nación quiere que hagan, esa es el área que realmente me preocupa. »

Las empresas deben estar a la altura del desafío

Las empresas corren el riesgo de perdiendo la guerra de la IA si no se mantienen a la par con el rápido ritmo de los atacantes que utilizan la IA como arma para ataques deepfake y todas las demás formas de IA adversaria. Los deepfakes se han vuelto tan comunes que Departamento de Seguridad Nacional publicó una guía, Las crecientes amenazas de las identidades falsas.