Suscríbase a nuestros boletines diarios y semanales para recibir las últimas actualizaciones y contenido exclusivo que cubre IA de vanguardia. Más información

Los modelos de lenguaje grande (LLM) son muy eficaces para responder preguntas simples, pero requieren técnicas de estimulación especiales para manejar tareas complejas que requieren razonamiento y planificación. A menudo llamados técnicas del «Sistema 2», estos esquemas de incentivos mejoran las habilidades de razonamiento de los LLM al exigirles que generen pasos intermedios para resolver un problema.

Aunque efectivas, las técnicas del Sistema 2 ralentizan las aplicaciones LLM y las hacen computacionalmente costosas. En un nuevo artículo, investigadores de Meta FERIA aquí «Sistema de destilación 2”, una técnica que permite a los LLM realizar tareas complejas sin requerir pasos intermedios.

Sistema 1 y Sistema 2 en ciencias cognitivas y LLM

En ciencia cognitiva, el Sistema 1 y el Sistema 2 designan dos modos distintos de pensamiento. El Sistema 1 es rápido, intuitivo y automático. Es lo que usamos para reconocer patrones, hacer juicios rápidos o comprender símbolos familiares. Por ejemplo, utilizamos el Sistema 1 para identificar señales de tráfico, reconocer rostros y asociar símbolos básicos con su significado.

El pensamiento del Sistema 2, por otro lado, es lento, deliberado y analítico. Requiere un esfuerzo consciente y se utiliza para resolver problemas complejos, como manipular símbolos abstractos, resolver ecuaciones matemáticas o planificar un viaje.

Los LLM generalmente se consideran análogos al pensamiento del Sistema 1. Pueden generar texto muy rápidamente, pero tienen dificultades con tareas que requieren razonamiento y planificación deliberados.

En los últimos años, los investigadores de inteligencia artificial han demostrado que se puede hacer que los LLM imiten el pensamiento del Sistema 2 incitándolos a generar pasos de razonamiento intermedios antes de dar su respuesta final. Por ejemplo, la «Cadena de pensamiento» es una técnica de indicaciones que le pide al LLM que explique su proceso de razonamiento paso a paso, lo que a menudo conduce a resultados más precisos para las tareas de razonamiento lógico. Varias técnicas de indicaciones del Sistema 2 son adecuadas para diferentes tareas.

«Se ha demostrado que muchos de estos métodos producen resultados más precisos a través de este razonamiento explícito, pero esto generalmente conlleva un costo de inferencia y una latencia de respuesta mucho mayores», escriben los investigadores de Meta AI. «Debido a este último punto, muchos de estos enfoques no se utilizan en los sistemas de producción, que utilizan principalmente las generaciones del Sistema 1».

Sistema de destilación 2

Una observación interesante sobre el pensamiento del Sistema 2 en los humanos es que cuando realizamos repetidamente una tarea que requiere un esfuerzo deliberado, gradualmente se arraiga en nuestro Sistema 1. Por ejemplo, cuando aprendes a conducir, haces un gran esfuerzo consciente para controlar el coche, obedecer las normas de tráfico y moverse. Pero a medida que adquieres experiencia, conducir se convierte en algo natural. Ya no necesitas pensar en cada paso y puedes realizarlos de forma intuitiva y automática.

Este fenómeno inspiró a los investigadores de Meta AI a desarrollar un «sistema de destilación 2» para los LLM.

La destilación es una técnica común en el aprendizaje automático (ML), donde se utiliza un modelo más grande, llamado «maestro», para entrenar un modelo más pequeño, o «estudiante». Por ejemplo, los desarrolladores suelen utilizar modelos de límites como GPT-4 y Claude para generar ejemplos de entrenamiento para modelos más pequeños como Llama-2 7B.

Sin embargo, la destilación del Sistema 2 no utiliza un modelo de maestro separado. En cambio, los investigadores encontraron una manera de destilar el conocimiento obtenido de las capacidades de razonamiento del Sistema 2 en su generación rápida y computacionalmente eficiente del Sistema 1.

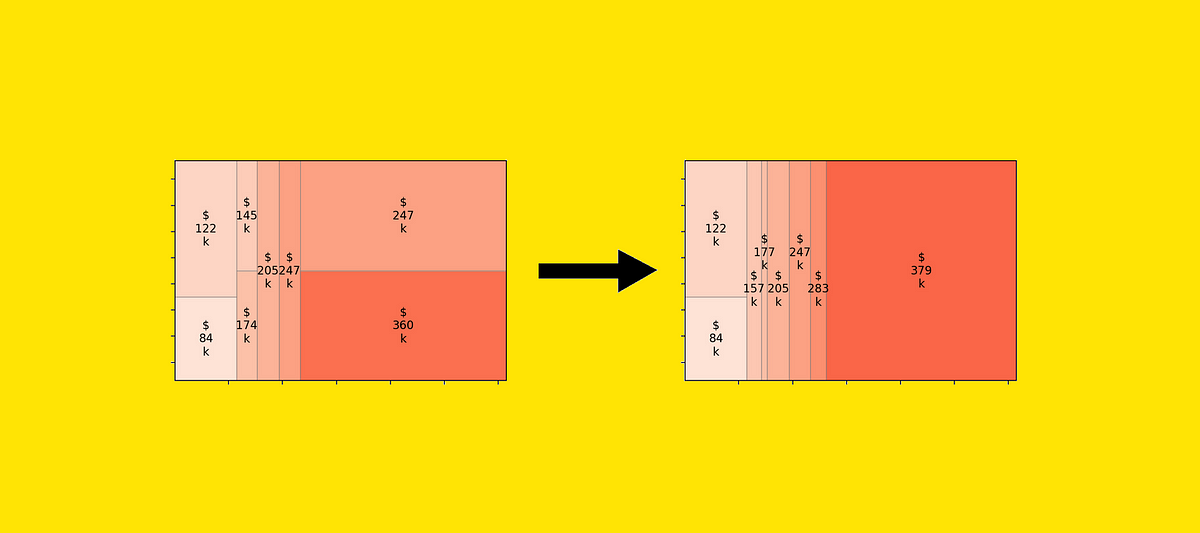

El proceso comienza pidiendo al LLM que resuelva un problema utilizando técnicas de indicaciones del Sistema 2. Luego se verifica que las respuestas sean correctas a través de un mecanismo no supervisado. Por ejemplo, utilizan la «autoconsistencia», donde el modelo recibe el mismo mensaje varias veces. Luego se comparan sus respuestas y la que aparece con mayor frecuencia se considera la respuesta correcta y se elige para el conjunto de datos de destilación. Si las respuestas son demasiado inconsistentes, se rechaza el ejemplo y sus respuestas.

Luego, eliminaron los pasos intermedios generados por el razonamiento del Sistema 2 y conservaron solo las respuestas finales. Finalmente, refinaron el modelo sobre la pregunta y respuesta iniciales. Esto permite al modelo omitir los pasos de razonamiento e ir directamente a la respuesta.

Sistema de destilación 2 en acción

Los investigadores evaluaron su método en una serie de tareas de razonamiento y cuatro técnicas diferentes de estimulación del Sistema 2. Para el modelo base, utilizaron Llama-2-70B, que es lo suficientemente grande como para tener la capacidad de internalizar nuevos conocimientos.

Los enfoques del Sistema 2 que utilizaron en sus experimentos incluyen cadena de pensamiento, Precaución del sistema 2, Reformular y responder y Rama-Resolver-Fusionar. Algunas de estas técnicas requieren que se consulte el modelo varias veces, lo que las hace lentas y costosas. Por ejemplo, Reformular y responder primero solicita al modelo que reformule la consulta original con una explicación, luego solicita al modelo nuevamente con la pregunta reformulada. Branch-Solve-Merge es aún más complicado y requiere varios viajes de ida y vuelta con el modelo.

Los resultados muestran que la destilación del Sistema 2 puede mejorar significativamente el rendimiento de los LLM en tareas de razonamiento complejas, a menudo igualando o superando la precisión de los métodos originales del Sistema 2. Además, los modelos destilados pueden generar respuestas mucho más rápido y con menos cálculos porque no tienen. pasar por pasos intermedios de razonamiento.

Por ejemplo, descubrieron que la destilación era efectiva para tareas que utilizan el Sistema 2 de Atención para lidiar con opiniones sesgadas o información irrelevante. También ha mostrado resultados impresionantes en algunas tareas de razonamiento, donde la función Reformular y Responder se utiliza para aclarar y mejorar las respuestas, y para una evaluación y procesamiento precisos de las tareas a través de Rama-Resolver-Fusionar.

«Hemos demostrado que en muchos casos es posible resumir este razonamiento del Sistema 2 en resultados de LLM sin generaciones intermedias manteniendo, o a veces incluso mejorando, el rendimiento», escriben los investigadores.

Sin embargo, los investigadores también descubrieron que, al igual que los humanos, los LLM no pueden sintetizar todos los tipos de habilidades de razonamiento en su mecanismo de inferencia rápida. Por ejemplo, no lograron destilar con éxito tareas complejas de razonamiento matemático que requirieran Incentivo de cadena de pensamientoEsto sugiere que algunas tareas aún podrían requerir un razonamiento deliberado.

Todavía hay mucho que aprender sobre la destilación del Sistema 2, incluido qué tan bien funciona en modelos más pequeños y cómo la destilación afecta el rendimiento general del modelo en tareas que no se incluyeron en el conjunto de datos de entrenamiento de Destilación. También cabe señalar que las pruebas de referencia de LLM suelen ser propensas a la contaminación, cuando el modelo ya tiene cierto conocimiento de los ejemplos de prueba, lo que genera resultados inflados en los conjuntos de pruebas.

Sin embargo, la destilación seguramente será una poderosa herramienta de optimización para procesos de LLM maduros que realizan tareas específicas en cada etapa.

«En el futuro, los sistemas que puedan sintetizar tareas útiles de esta manera liberarán más tiempo para pensar en tareas que aún no pueden realizar bien, tal como lo hacen los humanos», escriben los investigadores.