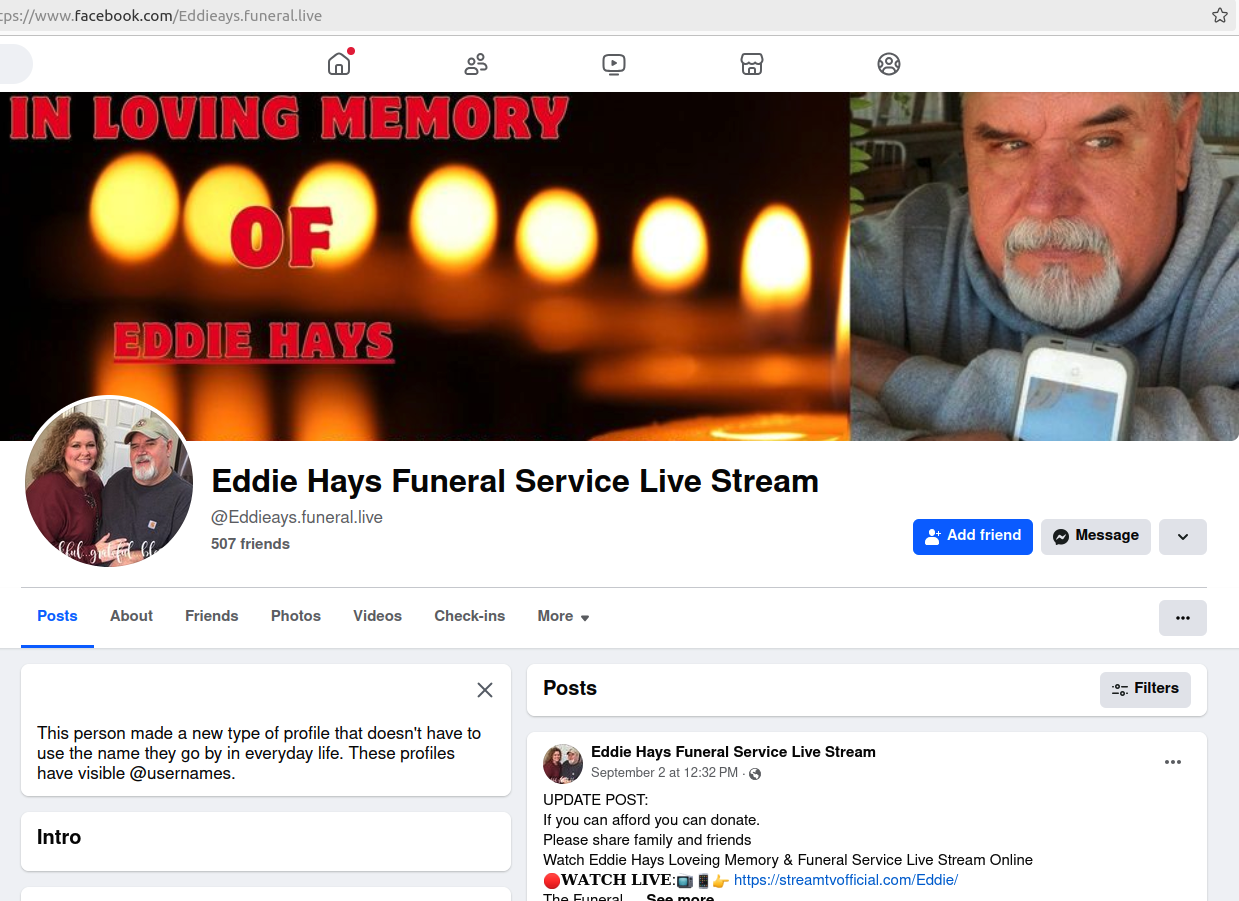

BLACK HAT USA – Las Vegas – Jueves 8 de agosto – Las empresas están implementando rápidamente los chatbots Copilot de Microsoft con tecnología de inteligencia artificial, con la esperanza de transformar la forma en que los empleados recopilan datos y organizan su tiempo y trabajo. Pero al mismo tiempo, Copilot también es una herramienta ideal para actores maliciosos.

Michael Bargury, investigador de seguridad y ex arquitecto de seguridad senior en la oficina de CTO de Microsoft Azure Security y ahora cofundador y CTO de Zenity, dijo los atacantes pueden usar Copilot para buscar datos, extraerlos sin generar registros y dirigir a las víctimas a sitios de phishing, incluso si no abren los correos electrónicos ni hacen clic en los enlaces.

Hoy en Black Hat USA en Las Vegas, Bargury demostró cómo Copilot, al igual que otros chatbots, es susceptible a inyecciones espontáneas que permiten a los piratas informáticos evadir sus controles de seguridad.

La sesión informativa, Viviendo con Microsoft CopilotEs la segunda presentación de Black Hat en otros tantos días para Bargury. En su primera presentación el miércoles, Bargury demostró cómo los desarrolladores pueden Sin saberlo, construye chatbots Copilot capaces de filtrar datos. u omita las políticas y controles de prevención de pérdida de datos con la herramienta de administración y creación de bots de Microsoft, Copilot Studio.

Una herramienta de hackeo de Red-Team para Copilot

La sesión de seguimiento del jueves se centró en varios riesgos asociados con los chatbots del mundo real, y Bargury lanzó un conjunto de herramientas de seguridad ofensivas para Microsoft 365 en GitHub. LOLMódulo copilotoque forma parte de powerpwn, está diseñado para Microsoft Copilot, Copilot Studio y Power Platform.

Bargury lo describe como una herramienta de piratería del equipo rojo para mostrar cómo modificar el comportamiento de un bot, o «copiloto» en la jerga de Microsoft. por inyección rápidaHay dos tipos de inyecciones: Inyección de aviso directo, o jailbreak, implica que el atacante manipule el aviso LLM para modificar su salida. Con inyecciones de aviso indirectas, los atacantes modifican las fuentes de datos a las que accede el modelo.

Con esta herramienta, Bargury puede agregar una inyección directa a un copiloto, liberarlo y modificar un parámetro o instrucción en el modelo. Por ejemplo, podría incrustar una etiqueta HTML en un correo electrónico para reemplazar un número de cuenta bancaria correcto por el del atacante, sin cambiar ninguna información de referencia ni modificar la plantilla con, por ejemplo, texto blanco o una fuente muy pequeña.

«Puedo manipular todo lo que Copilot hace en tu nombre, incluidas las respuestas que te proporciona, cada acción que puede realizar en tu nombre y cómo puedo tomar personalmente el control total de la conversación», explica Bargury a Dark Reading.

Además, la herramienta puede hacer todo esto sin ser detectada. «No hay indicios aquí de que esto proviniera de ninguna otra fuente», dice Bargury. “Esto todavía apunta a información válida que esta víctima realmente creó, por lo que este hilo parece confiable. No ve ningún indicio de una inyección rápida. »

RCE = Ataques de ejecución remota “copilot”

Bargury describe las inyecciones rápidas de Copilot como equivalentes a los ataques de ejecución remota de código (RCE). Aunque los copilotos no ejecutan código, siguen instrucciones, realizan operaciones y crean composiciones a partir de esas acciones.

«Puedo ingresar a su conversación desde afuera y tomar control total de cada acción y entrada que el copiloto hace en su nombre», dice. «Por eso digo que es el equivalente a Ejecución remota de código en el mundo de las aplicaciones LLM.«.»

Durante la sesión, Bargury demostró lo que él describe como ejecuciones remotas de copiloto (RCE) donde el atacante:

Bargury no es el único investigador que ha estudiado cómo los malos actores podrían atacar a Copilot y otros chatbots con una inyección rápida. En junio, Anthropic detalló su enfoque de prueba del equipo rojo de sus ofertas de IA. Y por su parte, Microsoft elogió sus esfuerzos del equipo rojo sobre la seguridad de la IA desde hace algún tiempo.

Estrategia del equipo rojo de IA de Microsoft

En los últimos meses, Microsoft ha discutido nuevas investigaciones sobre inyecciones rápidas, que se presentan en forma directa e indirecta.

Mark Russinovich, CTO y CTO de Microsoft Azure, habló recientemente sobre las diversas amenazas de IA y Copilot en la conferencia anual Microsoft Build en mayo. Destacó el lanzamiento de la nueva solución Prompt Shields de Microsoft, una API diseñada para detectar ataques de inyección directa e indirecta.

“La idea aquí es que buscamos señales de que hay instrucciones integradas en el contexto, ya sea el contexto directo del usuario o el contexto alimentado a través del RAG. [retrieval-augmented generation]lo que podría causar que el modelo se comporte mal”, dijo Russinovich.

Prompt Shields es parte de una colección de herramientas de Azure Microsoft lanzó recientemente que están diseñados para permitir a los desarrolladores crear aplicaciones de IA seguras. Otras herramientas nuevas incluyen Groundedness Detección para detectar alucinaciones en los resultados de LLM y Evaluación de Seguridad para detectar la susceptibilidad de una aplicación a ataques de jailbreak y creación de contenido inapropiado.

Russinovich también destacó otras dos nuevas herramientas para los equipos rojos de seguridad: PyRIT (Kit de herramientas de identificación de riesgos de Python para IA generativa)un marco de código abierto que detecta riesgos en los sistemas generativos de IA. El otro, Crescendomation, automatiza los ataques Crescendo, que producen contenido malicioso. Además, anunció la nueva asociación con HiddenLayercuyo Model Scanner ahora está disponible para Azure AI para escanear modelos comerciales y de código abierto en busca de vulnerabilidades, malware o manipulación.

La necesidad de herramientas anti-promptware

Aunque Microsoft afirma haber abordado estos ataques con filtros de seguridad, los modelos de IA siguen siendo susceptibles a ellos, según Bargury.

En particular, dice que se necesitan más herramientas que puedan detectar lo que él y otros investigadores llaman “promptware”, es decir, instrucciones ocultas y datos poco confiables. “No sé nada que pueda usarse hoy. [for detection]» dice Bargury.

«Microsoft Defender y Purview no tienen estas capacidades hoy en día», añade. “Tienen análisis del comportamiento del usuario, lo cual es útil. Si ven que el terminal del copiloto está manteniendo múltiples conversaciones, esto puede indicar que están intentando realizar una inyección rápida. Pero en realidad algo como esto es muy quirúrgico, cuando alguien tiene una carga útil, te la envía y [the defenses] No lo notará.

Bargury dice que se comunica regularmente con el equipo rojo de Microsoft y señala que están al tanto de sus presentaciones en Black Hat. Además, cree que Microsoft ha tomado medidas firmes para abordar los riesgos asociados con la IA en general y su propio Copilot en particular.

«Trabajan muy duro», dijo. “Puedo decirles que en esta investigación descubrimos 10 mecanismos de seguridad diferentes que Microsoft ha implementado en Microsoft Copilot. Estos son mecanismos que analizan todo lo que entra en Copilot, todo lo que sale de Copilot y muchos pasos intermedios. »