Por John P. Desmond, editor de tendencias de IA

La pila de IA definida por la Universidad Carnegie Mellon es fundamental para el enfoque que adopta el ejército de los EE. UU. en sus esfuerzos de desarrollo de plataformas de IA, según Isaac Faber, científico jefe de datos del Centro de Integración de IA del Ejército de los EE. UU., hablando en la conferencia. Gobierno global de IA evento celebrado en persona y virtualmente desde Alexandria, Virginia, la semana pasada.

«Si queremos que las fuerzas armadas avancen hacia la modernización digital, uno de los mayores problemas que he encontrado es la dificultad de abstraer las diferencias entre aplicaciones», dijo. “El elemento más importante de la transformación digital es la capa intermedia, la plataforma que facilita el paso de la nube al escritorio local. » El objetivo es poder trasladar su plataforma de software a otra plataforma, con la misma facilidad con la que un nuevo teléfono inteligente transfiere los contactos y el historial del usuario.

La ética atraviesa todas las capas de la pila de aplicaciones de IA, colocando la fase de planificación en la parte superior, seguida por el apoyo a las decisiones, el modelado, el aprendizaje automático, la gestión de big data y la capa de dispositivo o plataforma en la parte inferior.

«Abogo por considerar la pila como una infraestructura central y una forma de implementar aplicaciones, sin aislarlas en nuestro enfoque», dijo. “Necesitamos crear un entorno de desarrollo adecuado para una fuerza laboral distribuida globalmente. »

El Ejército está trabajando en una plataforma de software de entorno operativo común (Coes), anunciada por primera vez en 2017, un diseño para el trabajo del DOD que es escalable, ágil, modular, portátil y abierto. «Es adecuado para una amplia gama de proyectos de IA», afirmó Faber. Cuando se trata de ejecutar el esfuerzo, “el diablo está en los detalles”, afirmó.

El Ejército está trabajando con CMU y empresas privadas en una plataforma prototipo, incluso con visimo de Coraopolis, Pensilvania, que ofrece servicios de desarrollo de IA. Faber dijo que prefiere colaborar y coordinar con la industria privada en lugar de comprar productos disponibles en el mercado. «El problema es que estás estancado en el valor que obtienes de este único proveedor, que generalmente no está diseñado para los desafíos de las redes del DOD», dijo.

El ejército entrena una serie de equipos técnicos de IA

El Ejército está participando en esfuerzos de desarrollo de la fuerza laboral de IA para múltiples equipos, incluidos líderes, profesionales graduados, personal técnico que se está capacitando para obtener la certificación y usuarios de IA.

Los equipos técnicos del ejército tienen diferentes áreas de enfoque, que incluyen: desarrollo de software de propósito general, ciencia de datos operativos, implementación que incluye análisis y un equipo de operaciones de aprendizaje automático, como un equipo grande necesario para construir un sistema de visión por computadora. «A medida que las personas avanzan en la fuerza laboral, necesitan un lugar para colaborar, construir y compartir», dijo Faber.

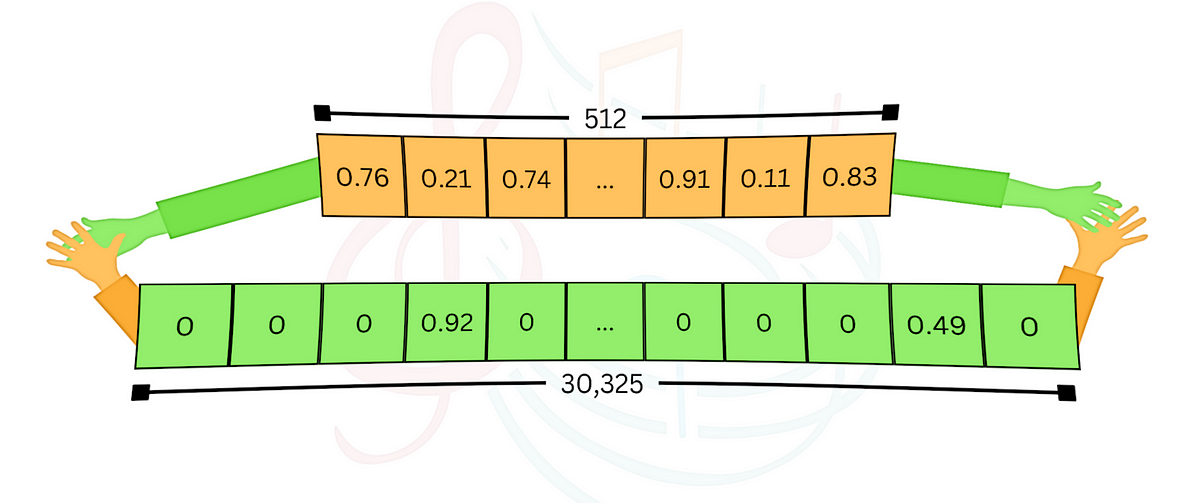

Los tipos de proyectos incluyen diagnóstico, que puede combinar flujos de datos históricos, predictivos y prescriptivos, que recomiendan un curso de acción basado en una predicción. “Al final está la IA; No empezamos con eso”, dijo Faber. El desarrollador necesita resolver tres problemas: la ingeniería de datos, la plataforma de desarrollo de IA, a la que llamó «la burbuja verde», y la plataforma de implementación, a la que llamó «la burbuja roja».

“Estas áreas son mutuamente excluyentes y todas están interconectadas. Estos equipos formados por diferentes personas deben coordinarse a nivel de programa. Normalmente, un buen equipo de proyecto incluye personas de cada una de estas áreas”, afirmó. “Si aún no lo has hecho, no intentes resolver el problema de la burbuja verde. No tiene sentido dedicarse a la IA hasta que tenga una necesidad operativa. »

Cuando un participante le preguntó qué grupo es el más difícil de alcanzar y capacitar, Faber respondió sin dudarlo: “Los más difíciles de alcanzar son los ejecutivos. Necesitan aprender qué valor debería aportar el ecosistema de IA. El mayor desafío es cómo comunicar ese valor”, afirmó.

Panel analiza los casos de uso de IA con mayor potencial

Durante un panel sobre los fundamentos de la IA emergente, el moderador Curt Savoie, director del programa Global Smart Cities Strategies para IDC, la firma de investigación de mercado, preguntó sobre el caso de uso de la IA emergente que tenía el mayor potencial.

Jean-Charles Lede, asesor técnico de autonomía de la Oficina de Investigación Científica de la Fuerza Aérea de EE. UU., dijo: “Yo enfatizaría los beneficios de la toma de decisiones en el borde, en apoyo de los pilotos y operadores, y las decisiones en segundo plano, para la misión. y planificación de recursos. »

Krista Kinnard, gerente de tecnologías emergentes del Departamento de Trabajo, dijo: «El procesamiento del lenguaje natural es una oportunidad para abrir las puertas a la IA en el Departamento de Trabajo», afirmó. “En última instancia, procesamos datos sobre personas, programas y organizaciones. »

Savoie preguntó cuáles son los principales riesgos y peligros que ven los panelistas al implementar la IA.

Anil Chaudhry, director de implementaciones federales de IA para la Administración de Servicios Generales (GSA), dijo que en una organización de TI típica que utiliza el desarrollo de software tradicional, el impacto de la decisión de un desarrollador sólo llega hasta cierto punto. Con la IA, “hay que considerar el impacto en toda una clase de personas, electores y partes interesadas. Con un simple cambio de algoritmo, se podrían retrasar los beneficios para millones de personas o realizar deducciones incorrectas a gran escala. Este es el mayor riesgo”, afirmó.

Dijo que les pide a sus socios contractuales que tengan “humanos informados y humanos informados”.

Kinnard apoyó esta afirmación y afirmó: “No tenemos ninguna intención de sacar a los humanos del circuito. Realmente se trata de empoderar a las personas para que tomen mejores decisiones.

Destacó la importancia de monitorear los modelos de IA después de su implementación. «Los modelos pueden variar según los cambios en los datos subyacentes», dijo. “Por lo tanto, se necesita un cierto nivel de pensamiento crítico no sólo para realizar la tarea, sino también para evaluar si lo que está haciendo el modelo de IA es aceptable. »

Añadió: “Hemos desarrollado casos de uso y asociaciones en todo el gobierno para asegurarnos de implementar una IA responsable. Nunca reemplazaremos a los humanos con algoritmos.

“A menudo tenemos casos de uso en los que los datos no existen. No podemos explorar datos de 50 años de guerra, por eso utilizamos simulación. El riesgo es enseñarle a un algoritmo que existe una “brecha entre la simulación y la realidad”, lo que constituye un riesgo real. No está claro cómo se adaptarán los algoritmos al mundo real”, dijo Lede de la Fuerza Aérea.

Chaudhry enfatizó la importancia de una estrategia de prueba para los sistemas de IA. Advirtió contra los desarrolladores «que se enamoran de una herramienta y olvidan el propósito del ejercicio». Recomendó que el gerente de desarrollo diseñara una estrategia de verificación y validación independiente. “Tus pruebas es donde necesitas concentrar tu energía como líder. El líder debe tener una idea en mente, antes de comprometer recursos, de cómo justificará si la inversión fue un éxito. »

Lede, de la Fuerza Aérea, habló sobre la importancia de la explicabilidad. “Soy tecnólogo. Yo no hago leyes. La capacidad de la función de IA para explicar de una manera con la que un humano pueda interactuar es importante. La IA es un socio con el que nos relacionamos, en lugar de llegar a una conclusión que no tenemos forma de verificar”, dijo.

Para obtener más información, visite Gobierno mundial de IA.