Los SDK de Meta’s Quest ahora permiten colocar objetos virtuales en superficies sin análisis de escena, mostrar un recorte de cualquier teclado y descubrir auriculares cercanos para su ubicación conjunta a través de Bluetooth.

La ubicación instantánea y el seguimiento del teclado están disponibles en Meta Mixed Reality Utility Kit (MRUK) versión 71, y el descubrimiento de colocación está disponible en Meta XR Core SDK versión 71.

Colocación instantánea

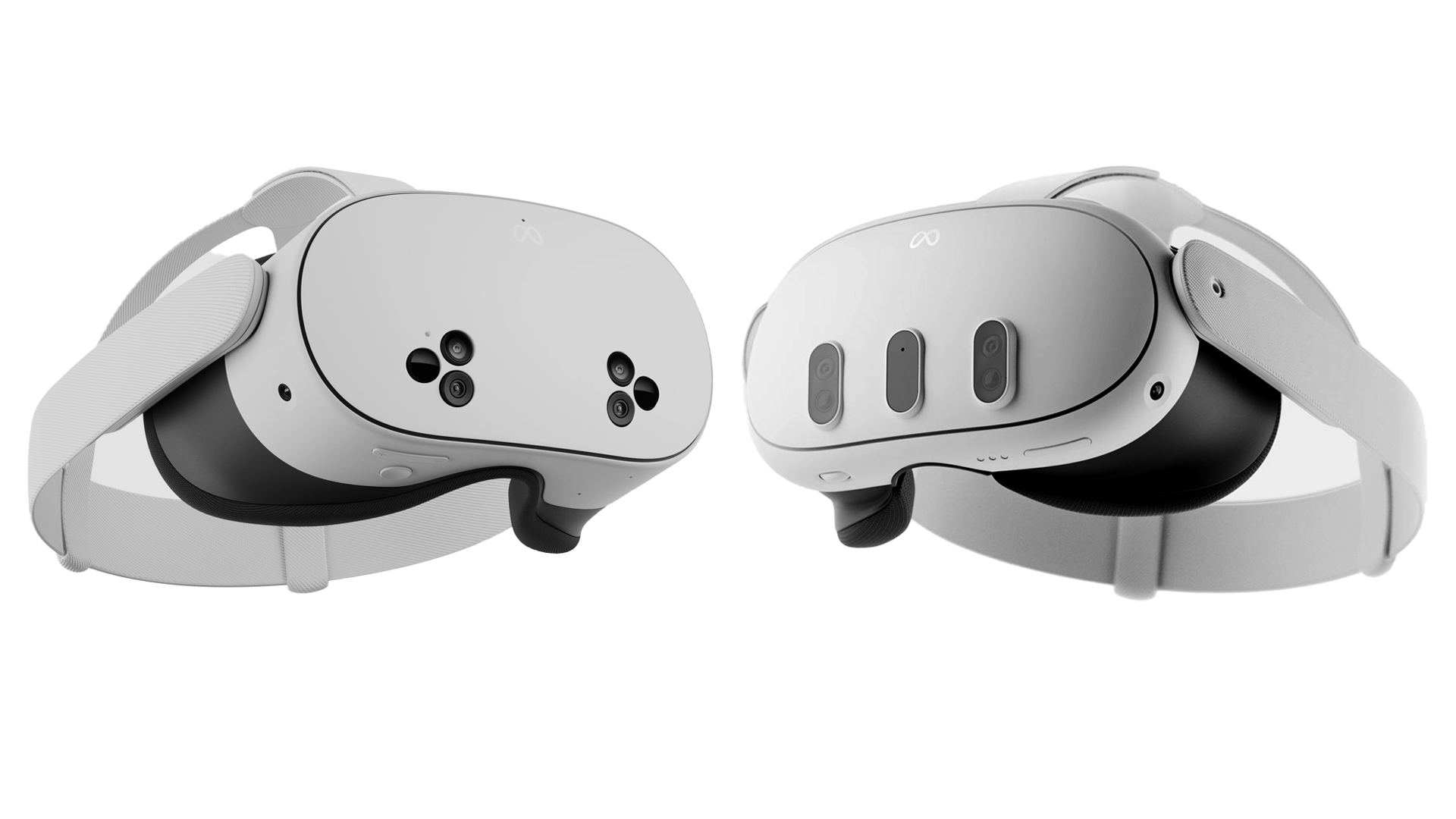

Muchas aplicaciones de realidad mixta colocan objetos virtuales en superficies reales, como su mesa o pared, aprovechando la malla de escena que Quest 3 y Quest 3S pueden generar a través del proceso opcional de configuración de la sala de realidad mixta.

Si una aplicación intenta operar Scene Mesh en una sala en la que el usuario no ha escaneado una, el usuario se verá obligado a realizar este proceso de configuración, que puede tardar hasta un minuto de rotación de la pantalla en la sala.

Eso es mucha fricción para una aplicación que tal vez solo necesite saber dónde está una mesa o una pared y eso es lo que la nueva función de Colocación Instantánea de MRUK pretende resolver.

Imágenes de colocación instantánea de VTuber CaféSingularidad.

En lugar de utilizar la malla de la escena, Instant Placement aprovecha la API de profundidad para proporcionar un raycast desde un controlador o una mano a una posición ocluida en el espacio 3D, lo que permite generar un objeto virtual o una interfaz en una superficie.

Sin embargo, tenga en cuenta que esto sólo es adecuado para generar interfaces y objetos estacionarios simples. Si necesitan moverse alrededor de la mesa o interactuar con el resto de la sala, Scene Mesh seguirá siendo necesario.

Recorte del teclado

Los Meta SDK incluyen una funcionalidad que le permite renderizar una versión virtual de seleccione compatible teclados rastreados desde hace años.

Pero intentar modelar todos los teclados Bluetooth posibles sería una batalla perdida, y en la versión 71 de Horizon OS Meta de Quest, se agregó la capacidad de rastrear cualquier teclado y silenciarlo mediante transferencia, en lugar de renderizar un modelo.

Imágenes del recorte del teclado de VTuber CaféSingularidad.

Ahora esta función también está disponible para desarrolladores de aplicaciones, como parte de MRUK. Esto significa que cualquier aplicación de realidad virtual que lo desee puede mostrar su teclado a través de un recorte de paso, especialmente útil para el software de productividad.

Virtual Desktop ha estado haciendo esto manualmente durante meses aprovechando el seguimiento de ciertos teclados compatibles. Ahora, en teoría, su desarrollador podría extender este soporte a cualquier teclado.

Descubrimiento de colocación de Bluetooth

Desde hace más de un año, los auriculares Quest admiten el modo multijugador local en el mismo espacio, conocido como colocación, a través de la API Shared Spatial Anchors.

Pero un importante punto de fricción en la creación de experiencias compartidas ha sido la necesidad de utilizar el mismo tipo de UX que el modo multijugador en línea, una invitación de contacto o un flujo de código de sala, que a menudo implica una secuencia de menú.

Quest 2 finalmente admite el modo multijugador local en espacio compartido

Quest 2 finalmente admite la colocación de espacios compartidos. “Coubicación” es el término para referirse a varios auriculares que comparten el mismo espacio físico de juego con el mismo espacio de coordenadas virtual. Facebook mostró un prototipo de la función «a escala de arena» a finales de 2018, pero no lo envió a un auricular hasta finales del año pasado.

Con la versión 71 del SDK Meta XR Core, Meta ahora tiene una API de descubrimiento de colocación. Debajo del capó, aprovecha la conectividad Bluetooth de los auriculares para permitirle enviar una pequeña cantidad de datos, 1.024 bytes, a auriculares cercanos para comunicar la configuración necesaria para unirse a una sesión.

En teoría, esto significa que los desarrolladores deberían poder crear una experiencia de usuario multijugador local simplificada en la que un auricular albergue una sesión y los auriculares cercanos se unan automáticamente a ella.