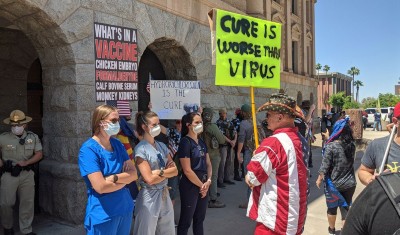

Las teorías de conspiración y la desinformación se han extendido rápidamente durante la pandemia de COVID-19. Crédito de la foto: Hollie Adams/Getty

Los investigadores han demostrado que la inteligencia artificial (IA) podría ser una herramienta valiosa en la lucha contra las teorías de la conspiración, al diseñar un chatbot que puede desacreditar información falsa y hacer que la gente cuestione su forma de pensar.

En un estudio publicado en Ciencia 12 de septiembre1Los participantes pasaron unos minutos interactuando con el chatbot, que les proporcionó respuestas y argumentos detallados, y experimentaron un cambio de mentalidad que duró meses. Este resultado sugiere que los hechos y las pruebas pueden en realidad cambiar las opiniones de las personas.

Tras los pasos de QAnon: cómo Trump trastocó la investigación sobre teorías de conspiración

«Este artículo realmente cuestiona gran parte de la literatura existente sobre la vida en una sociedad de posverdad», dice Katherine FitzGerald, que estudia teorías de conspiración y desinformación en la Universidad Tecnológica de Queensland en Brisbane, Inglaterra.

Análisis anteriores han sugerido que la gente se siente atraída por las teorías de la conspiración debido al deseo de seguridad y certeza en un mundo turbulento. Pero “lo que encontramos en este estudio va en contra de esta explicación tradicional”, dice Thomas Costello, coautor del estudio e investigador de psicología de la Universidad Americana en Washington DC. “Una de las aplicaciones potencialmente interesantes de esta investigación es que la IA podría usarse para desacreditar teorías de conspiración en la vida real. »

Ideas dañinas

Según las encuestas, alrededor del 50% de los estadounidenses cree en teorías de conspiración, que van desde la falsa hipótesis del alunizaje de 1969 hasta las vacunas contra el COVID-19 que contienen microchips que permiten una vigilancia masiva. El auge de las plataformas de redes sociales, que facilitan el intercambio de información, ha empeorado el problema.

Aunque muchas teorías de conspiración no tienen mucho impacto en la sociedad, aquellas que se difunden pueden «causar un daño real», dice FitzGerald. Cita como ejemplos el ataque del 6 de enero de 2021 al Capitolio de Estados Unidos, que fue motivado en parte por acusaciones de que las elecciones presidenciales de 2020 estaban amañadas, y la retórica antivacunas que afectó a las vacunas contra el COVID-19.

Es posible convencer a las personas para que cambien de opinión, pero puede llevar mucho tiempo y ser agotador. Además, la cantidad y diversidad de teorías de conspiración hacen que el problema sea difícil de abordar a gran escala. Pero Costello y sus colegas querían explorar el potencial de los modelos de lenguaje a gran escala (HLM), que pueden procesar rápidamente grandes cantidades de información y generar respuestas similares a las humanas, para abordar las teorías de la conspiración. «Fueron entrenados en Internet, conocen todas las teorías de conspiración y todas las refutaciones, y les pareció natural», dice Costello.

Por extraño que parezca

Los investigadores diseñaron un chatbot personalizado utilizando GPT-4 Turbo, el último LLM del creador de ChatGPT, OpenAI, con sede en San Francisco, California, que fue entrenado para argumentar de manera convincente contra las conspiraciones. Luego reclutaron a más de 1.000 participantes, cuyos datos demográficos se compararon con el censo de EE. UU. en términos de características como género y origen étnico. Costello explica que al reclutar «personas que han tenido diferentes experiencias de vida y que aportan sus propias perspectivas», el equipo pudo evaluar la capacidad del chatbot para desacreditar una variedad de conspiraciones.

La batalla épica contra la desinformación y las teorías de conspiración sobre el coronavirus

Se pidió a cada participante que describiera una teoría de la conspiración, explicara por qué pensaba que era cierta y expresara la fuerza de su creencia como porcentaje. Estos detalles se compartieron con el chatbot, que luego entabló una conversación con el participante, durante la cual señaló información y evidencia que debilitaban o desacreditaban la conspiración y respondía las preguntas del participante. Las respuestas del chatbot fueron completas y detalladas, y a menudo llegaron a cientos de palabras. En promedio, cada conversación duró aproximadamente 8 minutos.

El enfoque resultó eficaz: la confianza de los participantes en su teoría de la conspiración disminuyó en una media del 21% después de interactuar con el chatbot. Y el 25% de los participantes pasó de tener una confianza en sí mismos superior al 50%, a sentirse inseguro. El cambio fue insignificante para los grupos de control, que hablaron con el mismo chatbot durante un período de tiempo similar pero sobre un tema no relacionado. Una encuesta de seguimiento dos meses después mostró que el cambio de perspectiva había persistido para muchos participantes.

Si bien los resultados del estudio son prometedores, los investigadores señalan que los participantes fueron encuestados pagados y pueden no ser representativos de personas profundamente arraigadas en teorías de conspiración.

Intervención efectiva

FitzGerald está entusiasmado con el potencial de la IA para combatir las conspiraciones. «Si podemos intervenir y prevenir la violencia fuera de línea, eso siempre es algo bueno», afirma. Ella sugiere que los estudios de seguimiento podrían explorar diferentes métricas para evaluar la efectividad del chatbot, o replicar el estudio utilizando LLM con medidas de seguridad menos avanzadas para garantizar que no refuercen el pensamiento conspirativo.

Estudios anteriores han planteado preocupaciones sobre la tendencia de los chatbots de IA a «alucinar» información falsa. El estudio tuvo cuidado de evitar esta posibilidad: el equipo de Costello hizo que un verificador de datos profesional evaluara la exactitud de la información proporcionada por el chatbot, quien confirmó que ninguna de sus declaraciones era falsa o políticamente sesgada.

Costello dijo que el equipo planea realizar más experimentos para estudiar diferentes estrategias de chatbot, como probar qué sucede cuando las respuestas del chatbot no son educadas. Esperan que al identificar «experimentos en los que la persuasión ya no funciona» aprenderán más sobre por qué este estudio en particular tuvo éxito.