Los departamentos de policía suelen ser los primeros en adoptar nuevos productos tecnológicos, como drones, reconocimiento facial, software predictivo y, ahora, inteligencia artificial. Después de haber adoptado programas de transcripción de audio de IA, algunos departamentos ahora están probando una herramienta nueva y más completa: un software que aprovecha tecnología similar a ChatGPT para generar automáticamente informes policiales. Según un informe del 26 de agosto de Prensa asociadaMuchos agentes ya están “entusiasmados” con la herramienta de IA generativa que pretende reducir entre 30 y 45 minutos el trabajo rutinario de oficina.

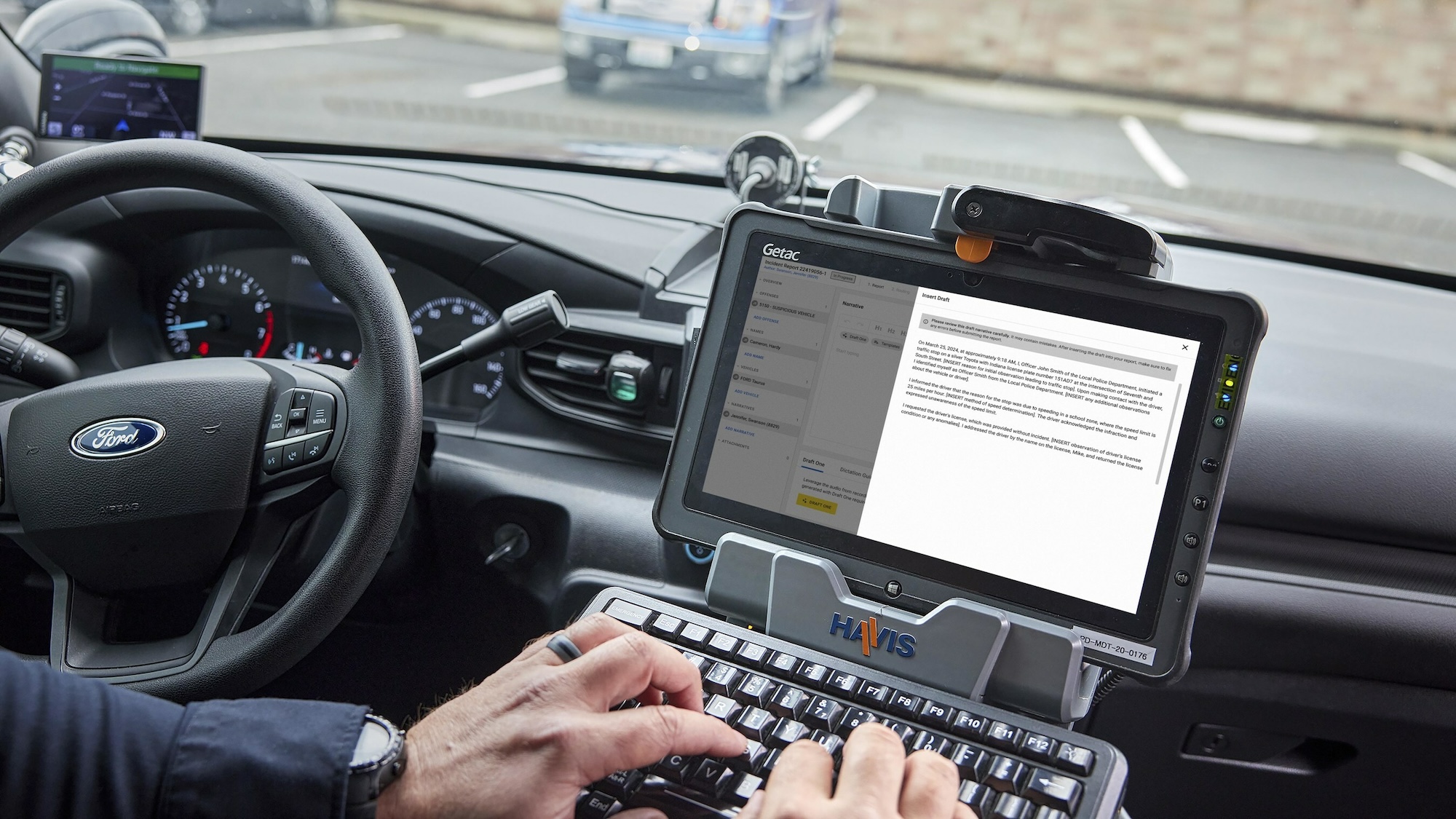

Anunciado originalmente En abril por Axon, Draft One se presenta como el “último paso gigante hacia [the] El objetivo final es reducir las muertes relacionadas con armas de fuego entre la policía y el público. » La compañía, mejor conocida por sus pistolas Taser y las líneas de cámaras corporales más populares para las fuerzas del orden, dice que sus pruebas iniciales reducen el papeleo en una hora por día para los usuarios.

«Cuando los agentes pueden dedicar más tiempo a comunicarse con la comunidad y cuidarse a sí mismos, tanto física como mentalmente, pueden tomar mejores decisiones que conduzcan a resultados más positivos en la reducción de la tensión», dijo Axon en su comunicado de prensa.

La compañía dijo en ese momento que Draft One está construido con Plataforma Azure OpenAI de Microsofty transcribe automáticamente el audio de la cámara corporal de la policía antes de «aprovechar la IA para crear rápidamente un borrador de la historia». Los informes están «escritos estrictamente a partir de la transcripción de audio» siguiendo la «plantilla subyacente del Borrador Uno… para evitar cualquier especulación o adorno». Una vez que se agrega información clave adicional, los agentes deben aprobar la precisión de un informe antes de que pase por otra ronda de revisión humana. Cada informe también se marca si AI participó en su redacción.

[Related: ChatGPT has been generating bizarre nonsense (more than usual).]

Hablar con AP El lunes, Noah Spitzer-Williams, gerente de productos de inteligencia artificial de Axon, afirmó que Draft One utiliza «la misma tecnología subyacente que ChatGPT». Diseñado por OpenAI, el modelo central de lenguaje generativo de ChatGPT ha sido frecuentemente criticado por su tendencia a proporcionar información engañosa o falsa en sus respuestas. Spitzer-Williams, sin embargo, compara las capacidades de Axon con «acceso a más botones y diales» que los que tienen los usuarios ocasionales de ChatGPT. Ajustar su «dial de creatividad» supuestamente ayudaría a Draft One a mantener sus informes policiales objetivos y evitar problemas persistentes de alucinaciones debido a la IA generativa.

El alcance de Draft One actualmente parece variar según los servicios. El capitán Jason Bussert del Departamento de Policía de la ciudad de Oklahoma dijo que su departamento de 1.170 agentes actualmente utiliza Draft One sólo para «informes de incidentes menores» que no involucran arrestos. Pero en Lafayette, Indiana, AP Según un informe, la policía que atiende a los aproximadamente 71.000 residentes de la ciudad tiene total libertad para utilizar Draft One «en cualquier tipo de caso». Los profesores de la Universidad Purdue, vecina de Lafayette, sostienen que la IA generativa simplemente no es lo suficientemente confiable para manejar situaciones que potencialmente alteran la vida, como los enfrentamientos con la policía.

“Los grandes modelos de lenguaje que sustentan herramientas como ChatGPT no están diseñados para generar la verdad. Más bien, encadenan oraciones plausibles basadas en algoritmos de predicción”, dice Lindsey Weinberg, profesora clínica asociada en Purdue especializada en ética digital y tecnológica, en una declaración a Divulgación científica.

[Related: ChatGPT’s accuracy has gotten worse, study shows.]

Weinberg, director del Laboratorio de Tecnología y JusticiaTambién sostiene que «se ha demostrado una y otra vez que casi todas las herramientas algorítmicas que se puedan imaginar reproducen y amplifican formas existentes de injusticia racial». documentado Hay muchos ejemplos de prejuicios raciales y de género en los principales patrones lingüísticos a lo largo de los años.

“El uso de herramientas que faciliten la generación de informes policiales en el contexto de un sistema legal que actualmente apoya y sanciona el encarcelamiento masivo de [marginalized populations] «Esto debería preocupar profundamente a quienes se preocupan por la privacidad, los derechos civiles y la justicia», dice Weinberg.

En un correo electrónico dirigido a Divulgación científicaUn representante de OpenAI sugirió que las consultas se dirijan a Microsoft. Axon, Microsoft y el Departamento de Policía de Lafayette no respondieron a las solicitudes de comentarios al momento de escribir este artículo.