Buenas noticias para los desarrolladores y entusiastas de la IA: Nvidia acaba de abaratar mucho la construcción de robots, drones, cámaras inteligentes y otros dispositivos impulsados por IA que requieren un cerebro. El nuevo Jetson Orin Nano Super de la compañía, anunciado el martes y ya disponible, ofrece más potencia de procesamiento que su predecesor y cuesta la mitad, 249 dólares.

La computadora del tamaño de la palma de la mano ofrece una mejora del rendimiento del 70%, alcanzando 67 billones de operaciones por segundo para tareas de IA. Este es un salto significativo con respecto a los modelos anteriores, especialmente para impulsar cosas como chatbots, visión por computadora y aplicaciones de robótica.

“Este es un Jetson Nano Super nuevo. Casi 70 billones de operaciones por segundo, 25 vatios y 249 dólares”, dijo el director ejecutivo de Nvidia, Jensen Huang, en un vídeo oficial revelado desde su cocina. «Ejecuta todo lo que hace el HGX, incluso ejecuta LLM».

El ancho de banda de la memoria también ha recibido una importante actualización, aumentando a 102 gigabytes por segundo, un 50% más rápido que la generación anterior del Jetson. Esta mejora significa que el dispositivo puede manejar modelos de IA más complejos y procesar datos de hasta cuatro cámaras simultáneamente.

El dispositivo viene con la GPU de arquitectura Ampere de Nvidia y un procesador ARM de 6 núcleos, lo que le permite ejecutar múltiples aplicaciones de IA a la vez. Esto brinda a los desarrolladores la oportunidad de trabajar con habilidades más variadas, como la construcción de pequeños modelos de robots que pueden realizar tareas como mapear un entorno, reconocimiento de objetos y comandos de voz con bajo consumo de energía.

Los propietarios actuales de Jetson Orin Nano tampoco se quedan fuera. Lanzamientos de Nvidia actualizaciones de software para aumentar la eficiencia de sus procesadores de IA más antiguos.

EL Números Detrás del nuevo Jetson Orin Nano Super de Nvidia se cuenta una historia interesante. Con solo 1.024 núcleos CUDA, eso parece modesto en comparación con los 1.920 núcleos del RTX 2060, los 3.584 del RTX 3060 o los 3.072 del RTX 4060, pero el recuento bruto de núcleos no cuenta toda la historia.

Mientras que las GPU para juegos como la serie RTX consumen entre 115 y 170 vatios de potencia, la Jetson sólo consume de 7 a 25 vatios. Eso es aproximadamente una séptima parte del consumo de energía de un RTX 4060, el más eficiente del grupo.

Las cifras del ancho de banda de la memoria muestran un panorama similar. Los 102 GB/s del Jetson pueden parecer decepcionantes en comparación con los más de 300 GB/s de las tarjetas RTX, pero están optimizados específicamente para cargas de trabajo de IA en el borde, donde el procesamiento eficiente de datos importa más que el rendimiento sin procesar.

Dicho esto, la verdadera magia ocurre en el rendimiento de la IA. El dispositivo genera 67 TOPS (billones de operaciones por segundo) para tareas de IA, una cifra difícil de comparar directamente con los TFLOPS de las tarjetas RTX porque miden diferentes tipos de operaciones.

pero en términos prácticosEl Jetson puede manejar tareas como ejecutar chatbots de IA locales, procesar múltiples transmisiones de cámaras y controlar robots, todo simultáneamente con un presupuesto de energía que apenas podría hacer funcionar el ventilador de refrigeración de la computadora portátil y una GPU para juegos, estando esencialmente codo a codo con un RTX 2060 a un precio razonable. fracción del costo y una fracción del consumo de energía.

Sus 8 GB de memoria compartida pueden parecer bajos, pero eso significa que funciona mejor que un RTX 2060 normal cuando se trata de ejecutar modelos de IA locales como Flux o Transmisión estable lo que puede generar un error de «memoria insuficiente» en estas GPU o descargar parte del trabajo a la RAM normal, reduciendo así el tiempo de inferencia, esencialmente el proceso de pensamiento de la IA.

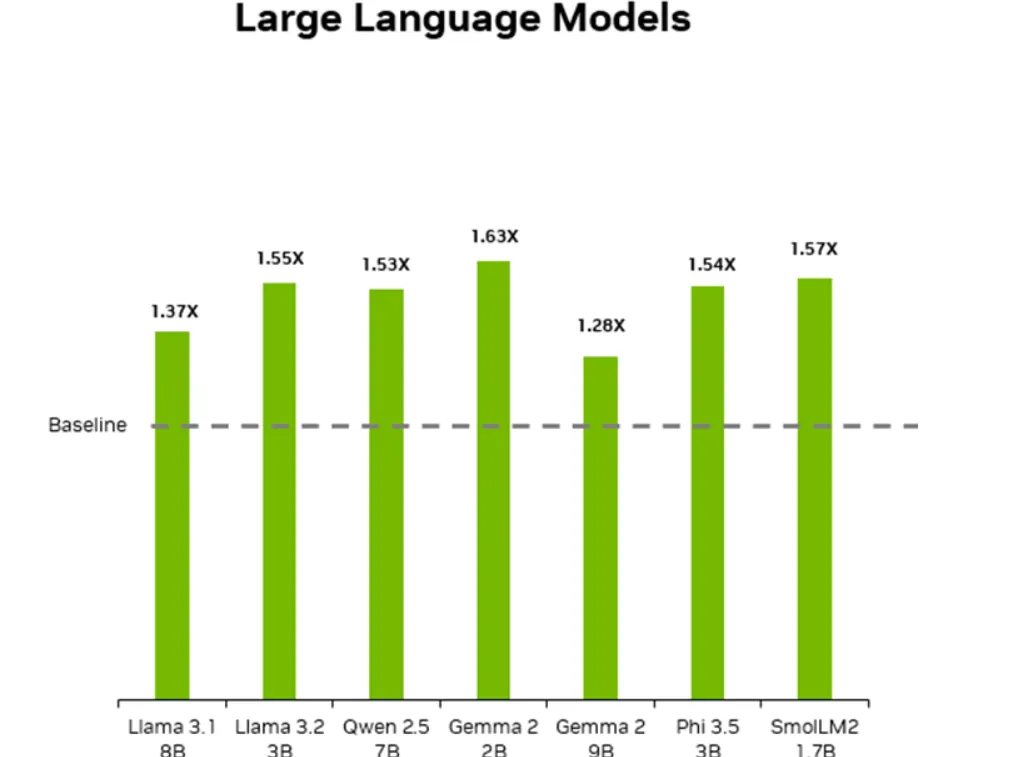

El Jetson Orin Nano Super también admite varios modelos de lenguaje pequeños y grandesincluidos aquellos con hasta 8 mil millones de parámetros, como el modelo Llama 3.1. Puede generar tokens a una velocidad de alrededor de 18 a 20 por segundo cuando se utiliza una versión cuantificada de estos modelos. Un poco lento, pero suficiente para algunas aplicaciones locales. Aún así, es una mejora con respecto a la generación anterior de modelos de hardware Jetson AI.

Teniendo en cuenta su precio y características, el Jetson Orin Nano Super está diseñado principalmente para la creación de prototipos y aplicaciones a pequeña escala. Para usuarios avanzados, empresas o aplicaciones que requieren amplios recursos informáticos, las capacidades del dispositivo pueden parecer limitadas en comparación con los sistemas de alta gama que cuestan mucho más y requieren mucha más energía.

Editado por Andrew Hayward.

Generalmente inteligente Hoja informativa

Un viaje semanal de IA narrado por Gen, un modelo de IA generativa.