El 100% de precisión no lo es todo: ayudar a los usuarios a navegar por el documento es el valor real

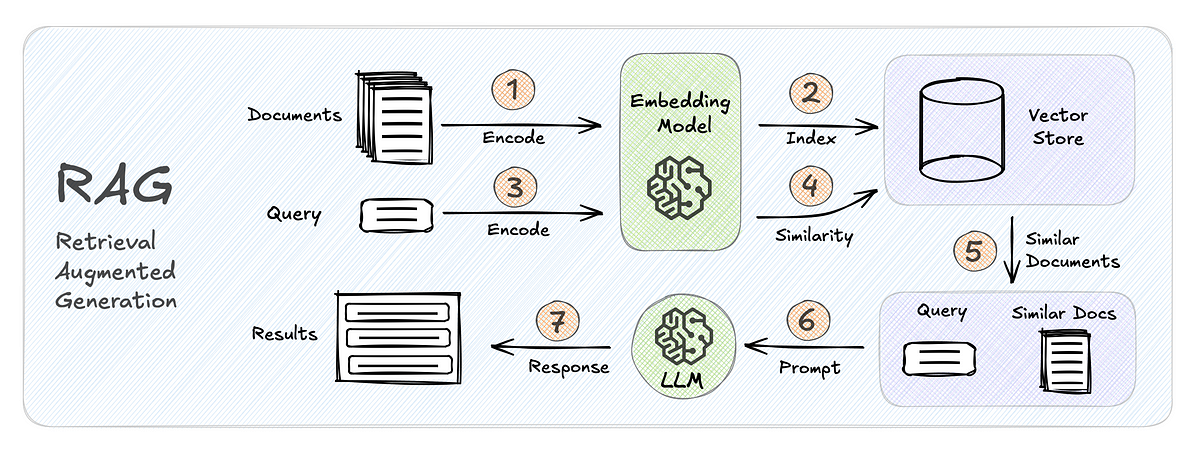

Entonces construyes un sistema RAG o usas un LLM para chatear con documentos. Pero los usuarios suelen preguntar: ¿cómo podemos confiar en las respuestas?

Además, a menudo oímos hablar de alucinaciones que minan la confianza de los usuarios.

Si creamos una aplicación pero no mostramos a los usuarios de dónde provienen las respuestas, la aplicación puede quedar inutilizable en algunos casos.

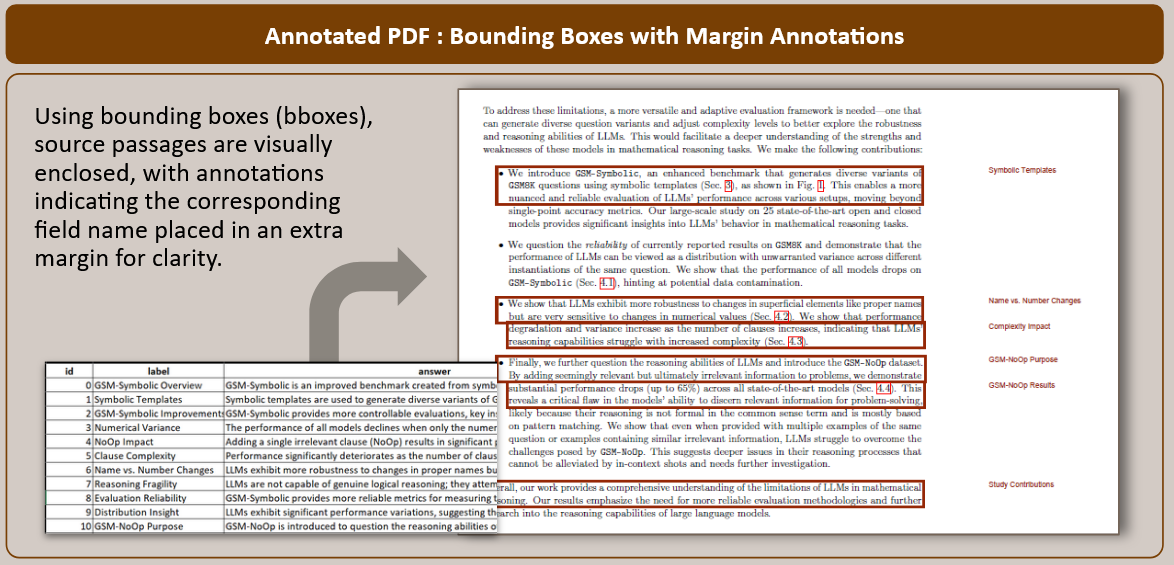

En este artículo, compartiré un enfoque para abordar esta preocupación. Al vincular cada respuesta generada por LLM con su texto fuente en el documento, podemos generar transparencia y confianza. Este método no sólo proporciona pruebas claras de las respuestas, sino que también permite a los usuarios comprobar los resultados directamente en el PDF.

A veces, la respuesta generada puede no ser perfectamente precisa, pero poder localizar el texto fuente correcto ya resulta útil para el usuario.

Tomemos un ejemplo de este documento en arxiv.org. Podemos imaginar este caso de uso:

El primer paso de este enfoque es extraer el texto del PDF en un formato estructurado.